chatGPT 的原理

#AI #chatGPT #agi

目录

1. 总结

- 计算里一切都是二进制

- 计算机如何把数字(二进制)和真实的世界建立联系呢?需要两步

- 第一步:向量化

- 首先初始化向量,完全没关系

- 然后训练,大量语料训练输入,修改维度值

- 第二步:信息压缩和特征提取

- 三种模型

- ① RNN(循环神经网络)

- 容易“健忘“(长期记忆困难)

- ② CNN(卷积神经网络)

- 就像你在看一幅画,先看局部细节,再组合成整体印象

- 处理图片很成熟,处理文本不理想

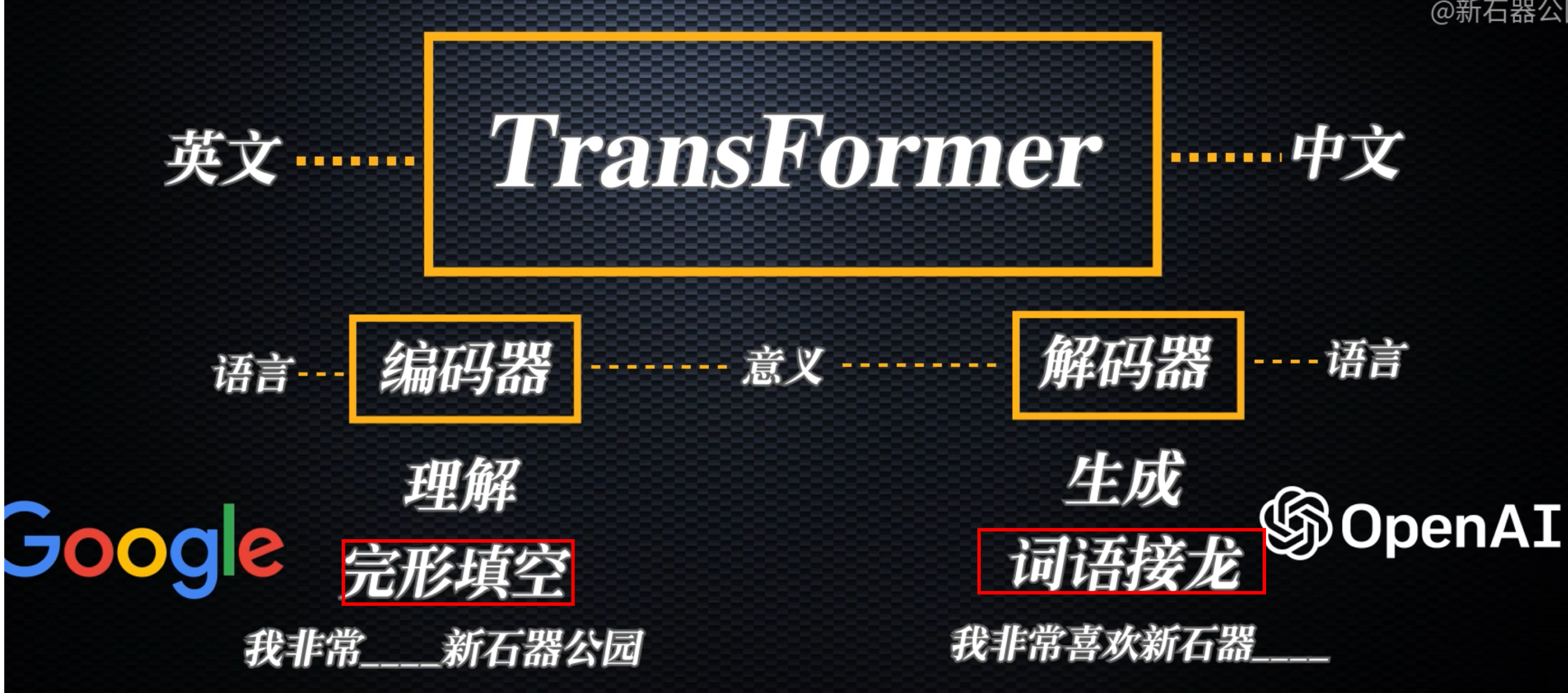

- ③ Transformer 模型

- 特点

- 可以同时看整个文档,不会随着文本变长而“忘记“前面的内容

- 因为都向量化了

- 能快速找到相关的信息

- 可以同时处理多个任务

- 可以同时看整个文档,不会随着文本变长而“忘记“前面的内容

- 使用这种机制训练,可以成功向量化

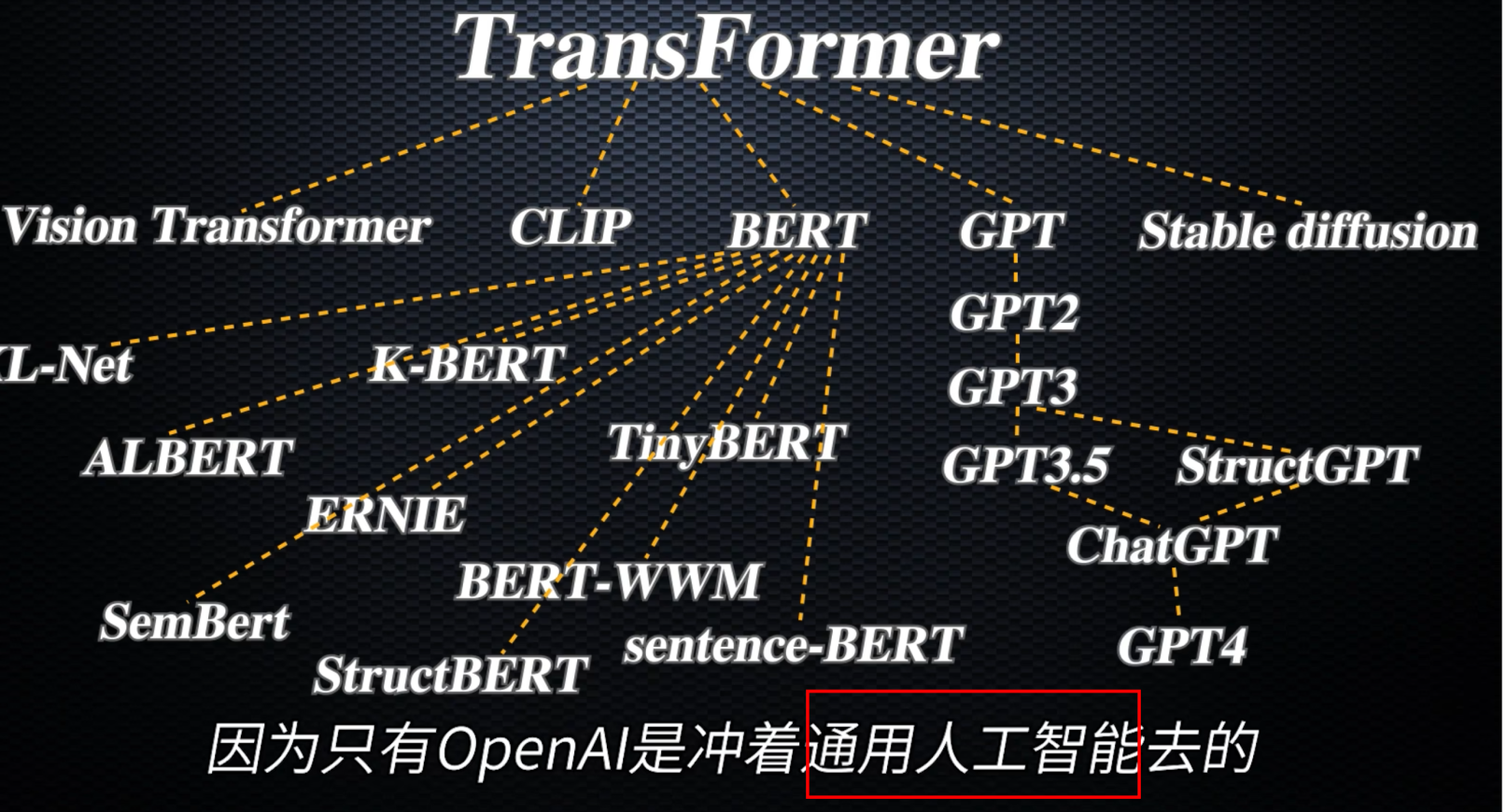

- OpenAI 的 GPT 系列、Google 的 BERT、以及其他主流大语言模型都采用了 Transformer 架构

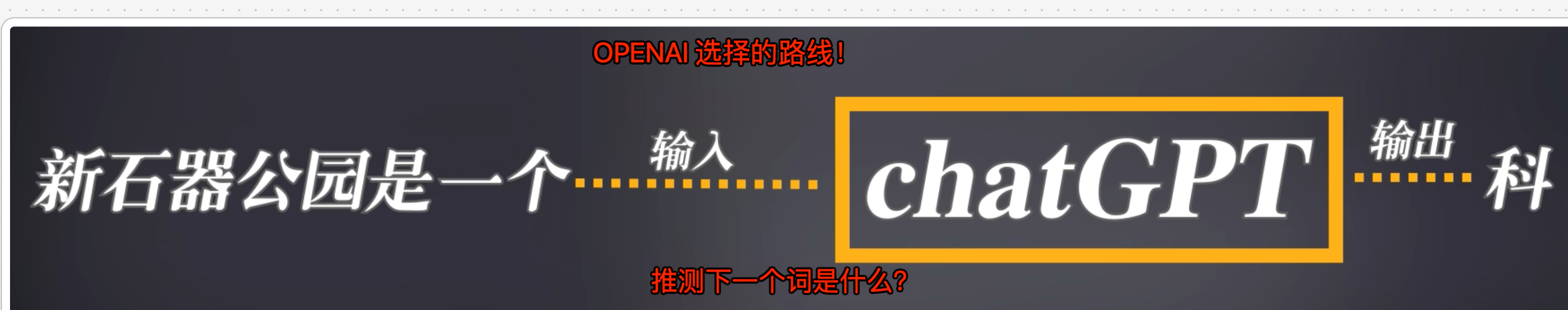

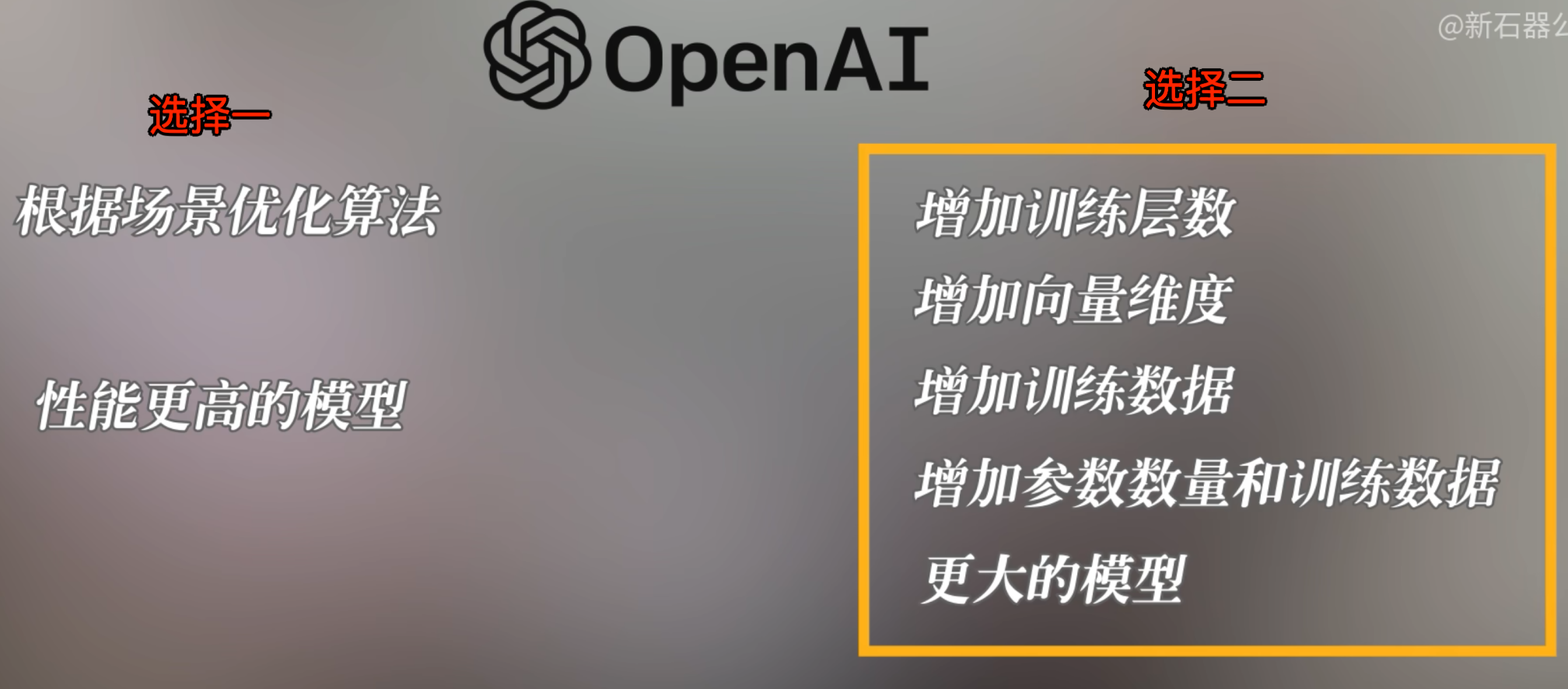

- OPENAI 的选择

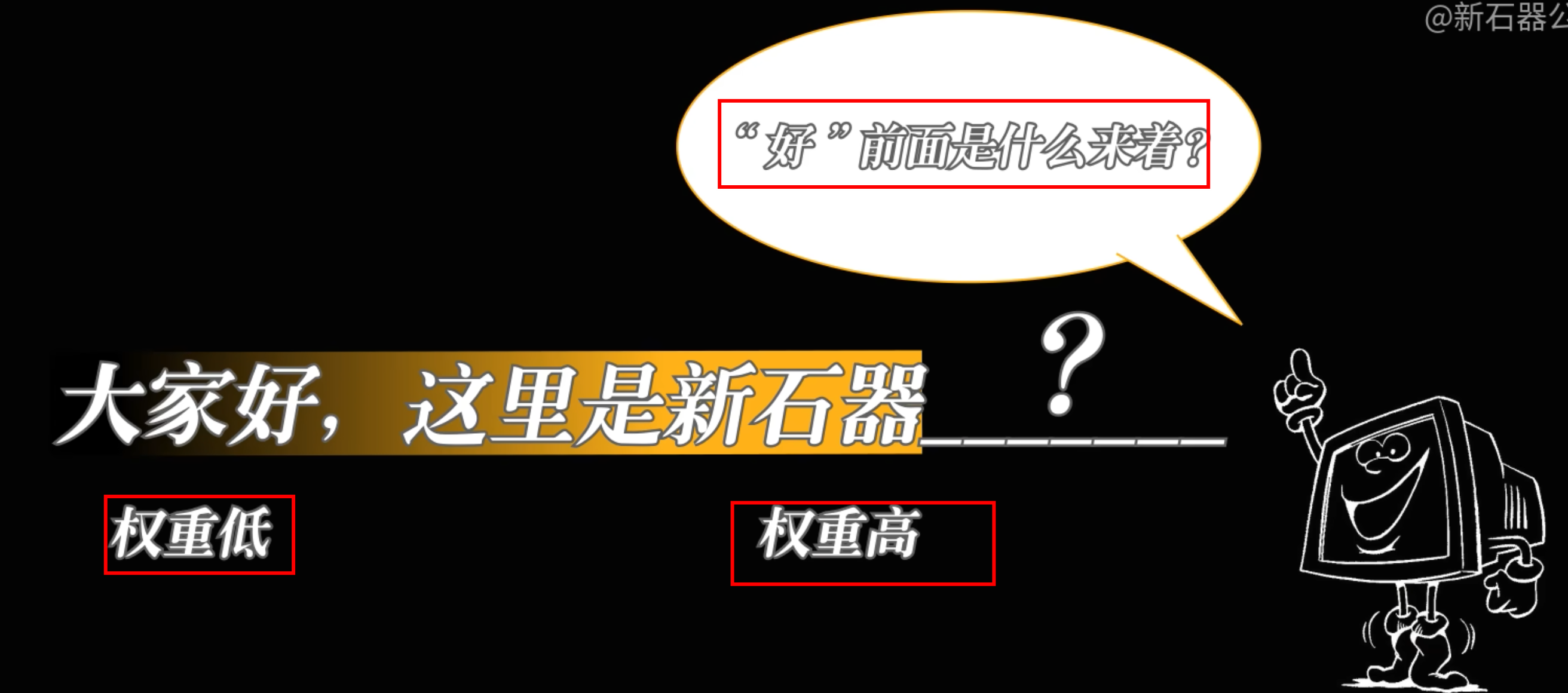

- 推测下一个词是什么

- OPENAI 的选择

- 特点

- ① RNN(循环神经网络)

- 三种模型

- 第一步:向量化

- 涌现:大力出奇迹

- 向量维度增加

- 训练数据增量

- 等等

2. 如何用计算机描述真实的世界?

一切都是二进制

- 字母

- 文本

- 图片最终存在计算机内也是二进制

- 即

rgba()

- 即

- 视频

- 其他等等

计算机如何把数字(二进制)和真实的世界建立联系呢?需要两步,如下

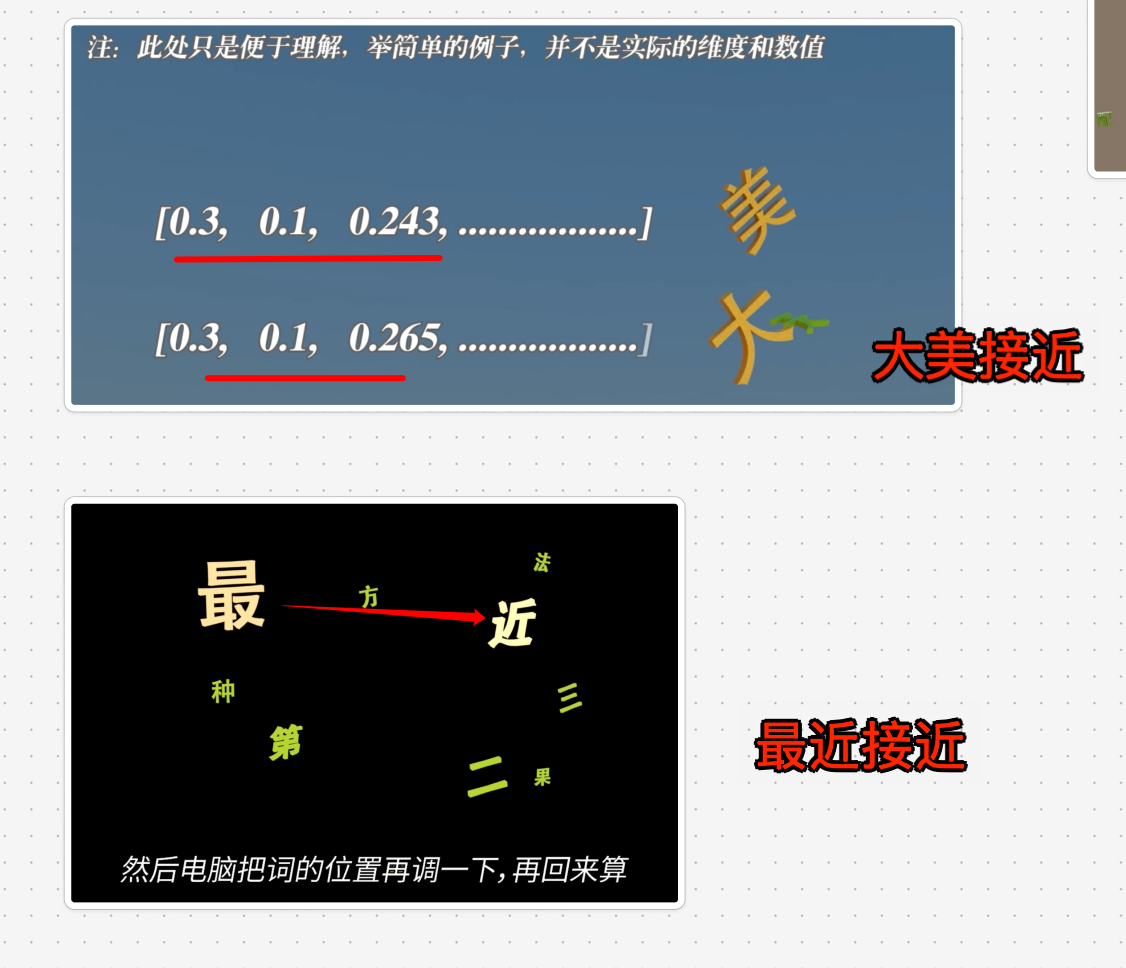

3. 第一步:向量化

为什么要向量化,两个原因:

- 方便电脑处理

- 方便寻找规律

3.1. 方便电脑处理

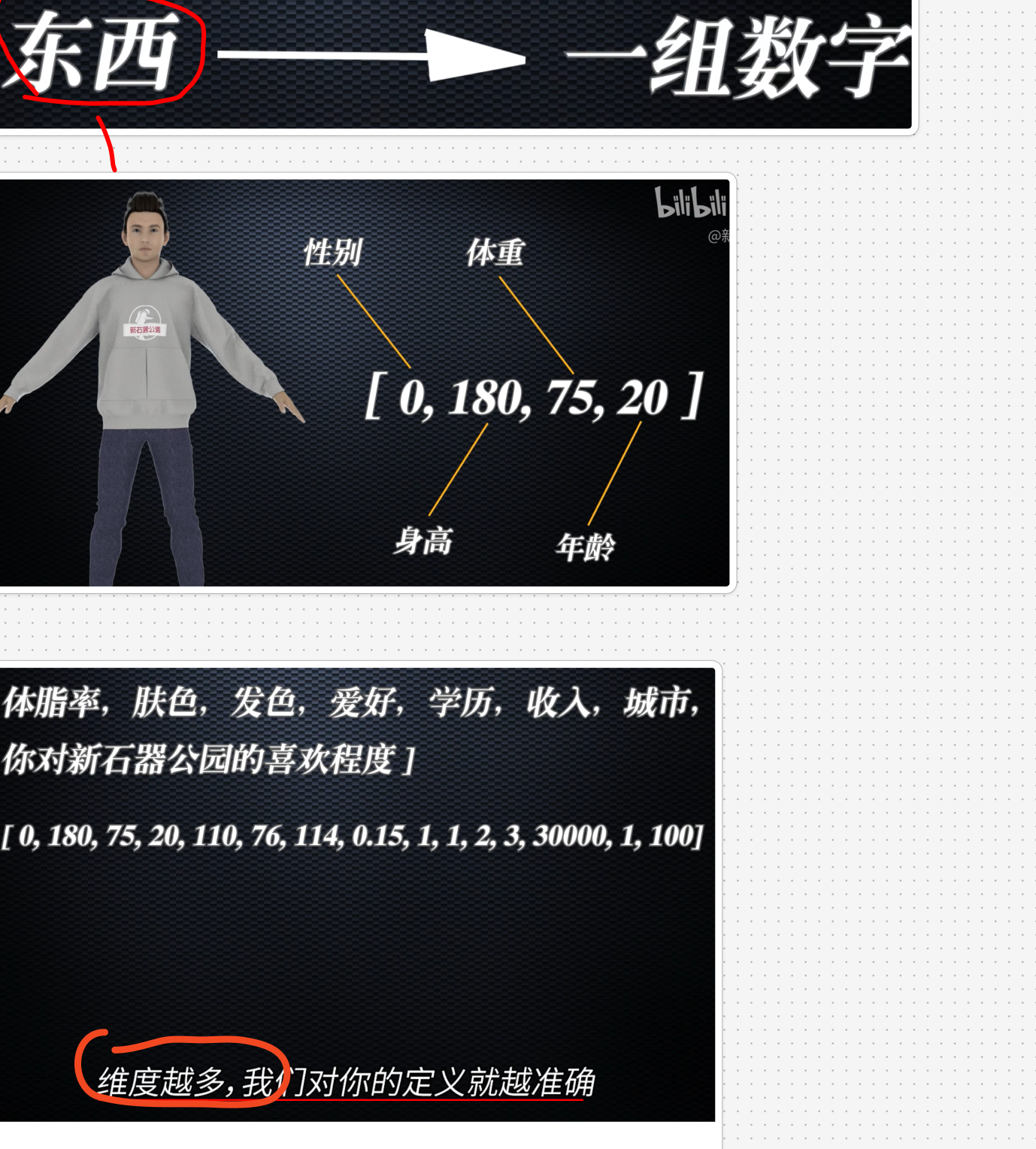

比如,如何描述一个人现实中的人了,如下图:

3.2. 方便寻找规律

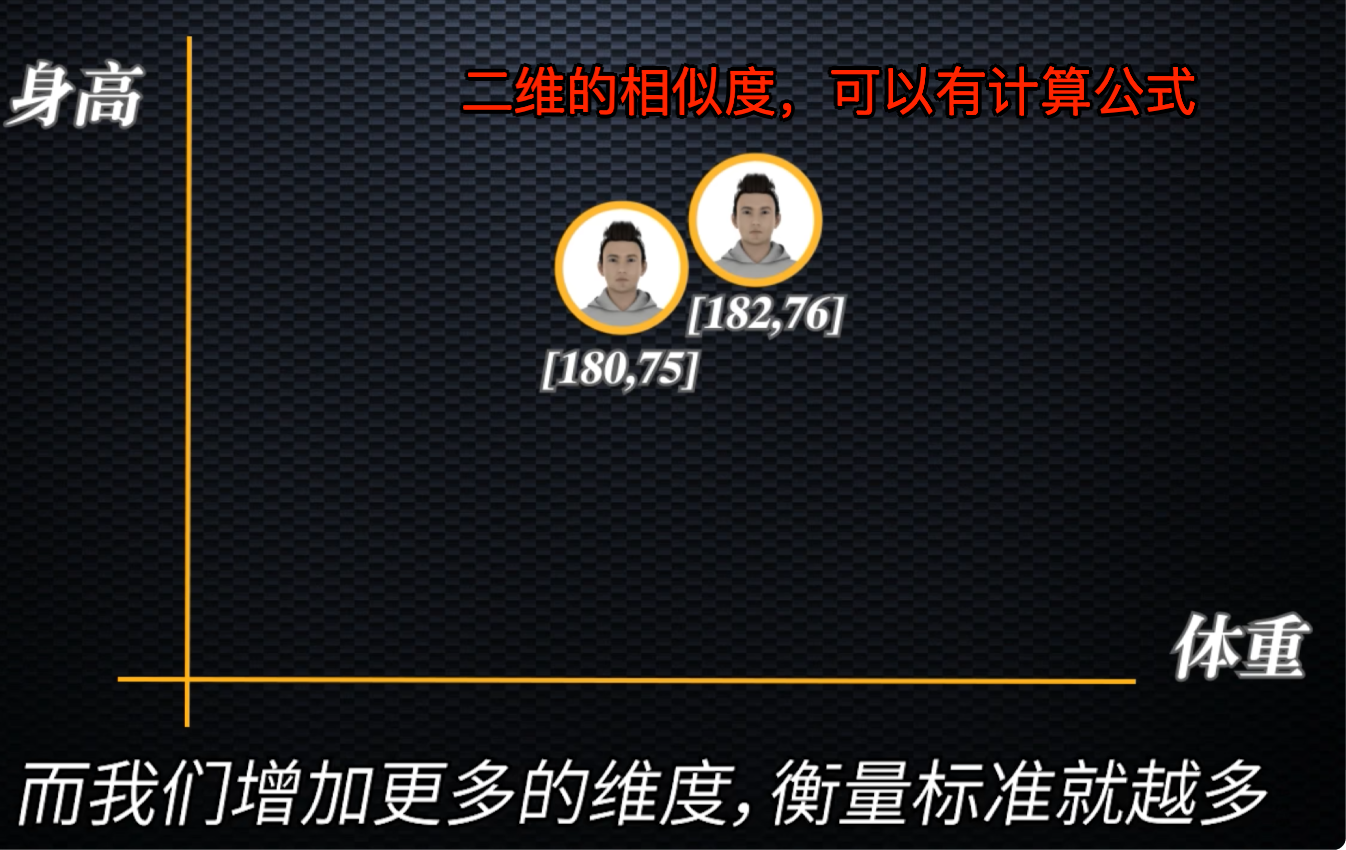

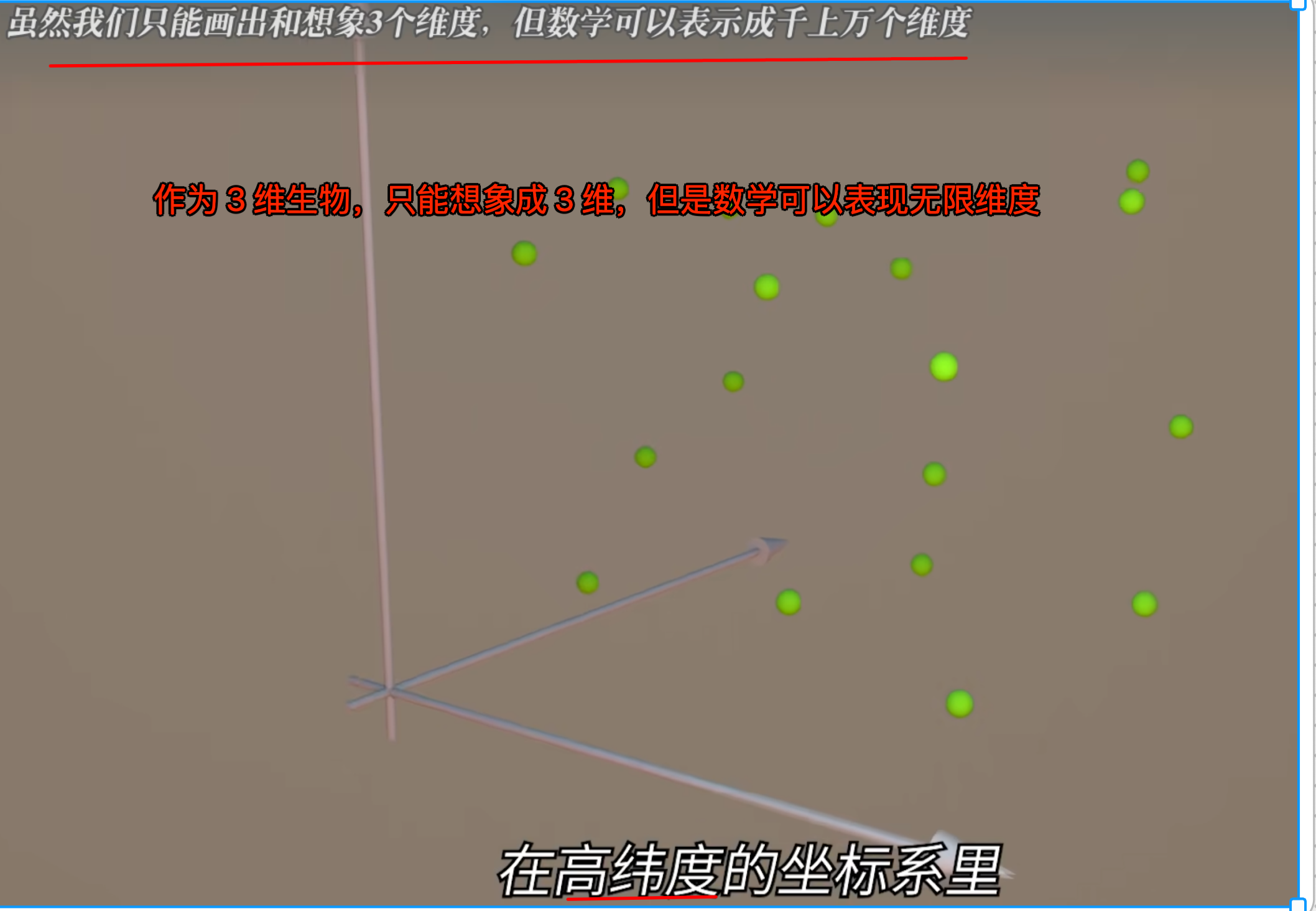

比如看两个人的相似度,如下图

3.3. 更高维度

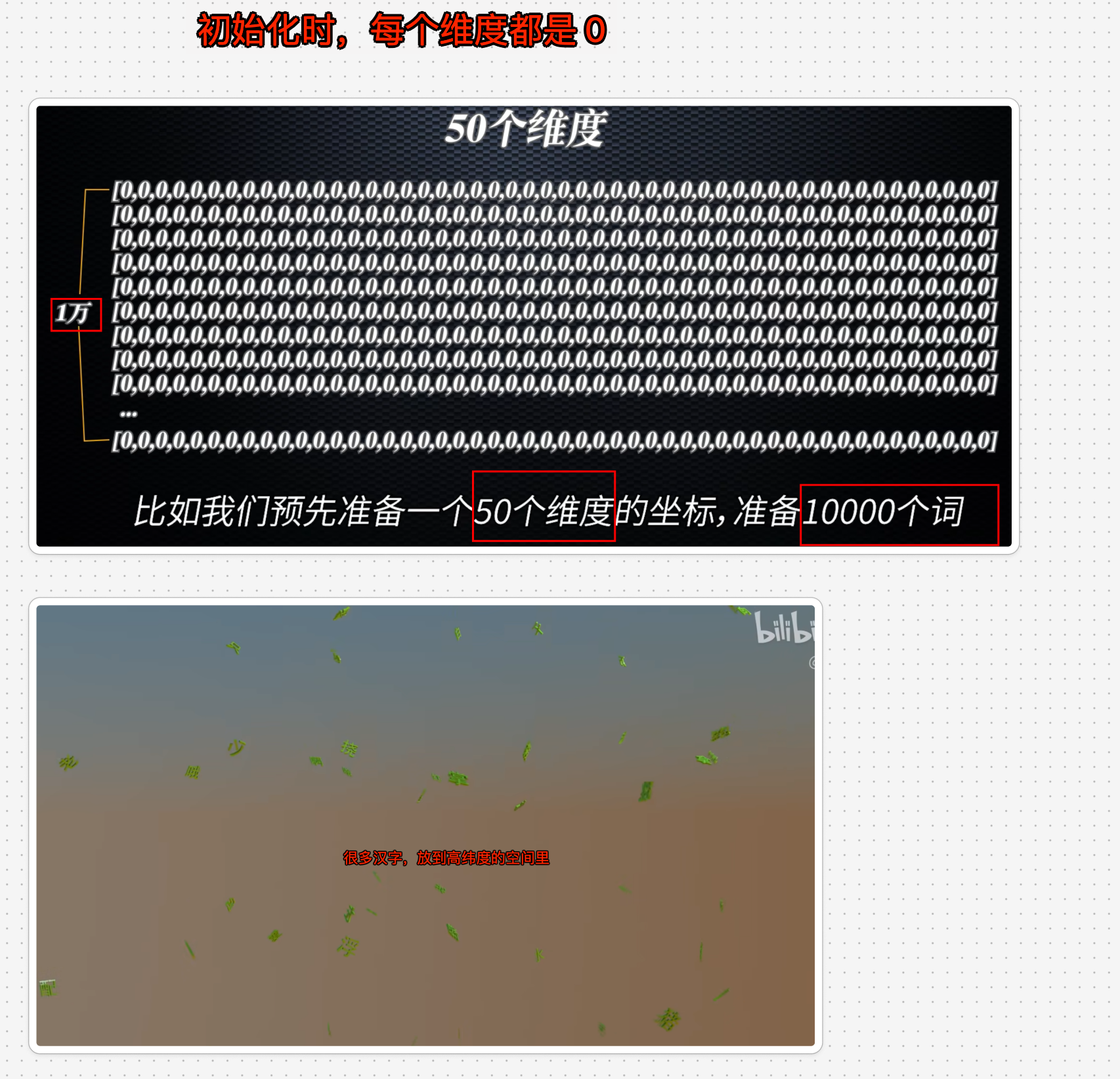

3.4. 初始化维度

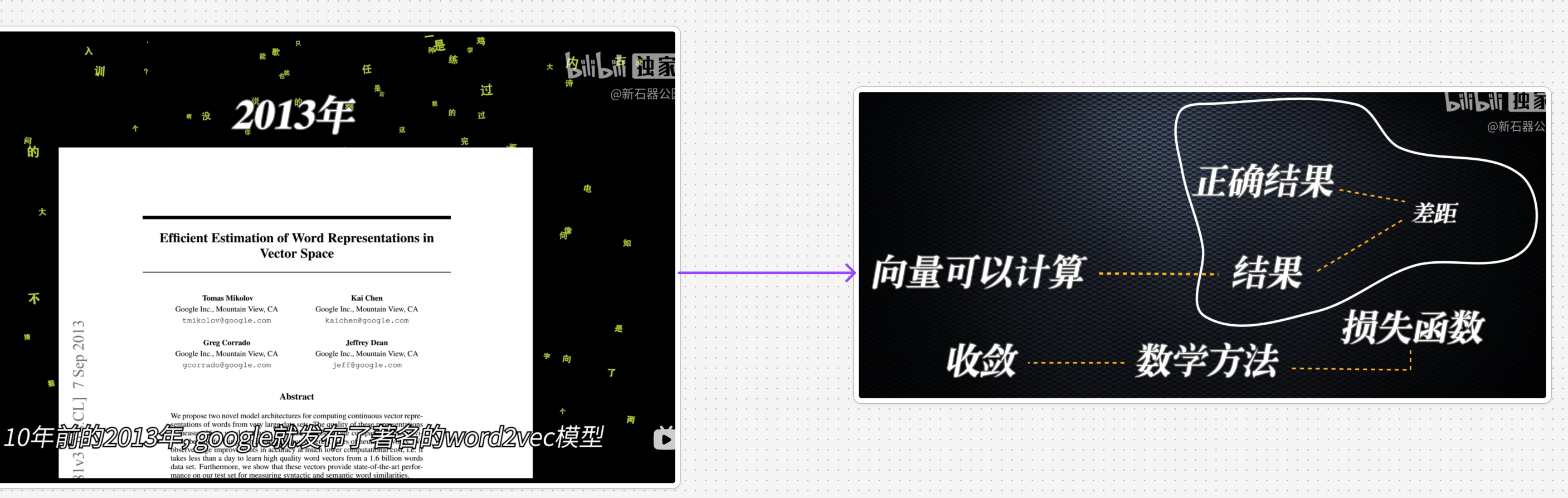

3.5. 如何训练修改维度值呢?

3.6. 大量语料训练输入,修改维度值

4. 第二步:信息压缩和特征提取

这一步,就是为了总结出正确的规律,计算出正确的向量值

4.1. CNN

现在图像识别之所以成熟,是因为找到了提取图像特征的方法,即 CNN

4.2. RNN

主要问题是会忘记前面说了啥?如下图

4.3. TransFormer

使用这种机制训练,可以让电脑成功向量化

各自发展路线图

4.4. OpenAI的选择

4.4.1. 生成

4.4.2. 增加参数

5. 涌现

选择二之后,大力出奇迹